La désambiguïsation sémantique permet de choisir le sens des unités lexicales polysémiques dans un texte. Elle s'effectue en tenant compte des contextes où un sens peut apparaître (Ide, Véronis, 1998). Il existe plusieurs méthodes pour réaliser cette désambiguïsation, soit en se référant à un corpus d'apprentissage réunissant des exemples d'instances désambiguïsées de mots (Navigli, 2009, Bakx, 2006), soit en utilisant des connaissances provenant de réseaux sémantiques (Tchechmedjiev, 2012, Lafourcade, 2011, Navigli, 2009). L'approche la plus directe consiste à estimer la proximité sémantique entre chaque sens candidat et chaque sens de chaque mot appartenant au contexte du mot à désambiguïser. Le principal problème de cette méthode est la rapide explosion combinatoire qu'elle engendre (complexité exponentielle).

Dans cet article, nous utilisons deux approches totalement différentes à base d'analyse distributionnelle permettant à la fois de réduire le nombre de combinaisons à évaluer et ne pas perdre une cohérence au niveau de la désambiguïsation voire même l'améliorer. Baroni et Lenci (2010) ont proposé un travail de synthèse sur les procédures relatives au calcul distributionnel. La clé de notre méthode de désambiguïsation est la sélection des voisins distributionnels les plus proches pour chaque mot polysémique dans le texte. La première approche d'analyse distributionnelle consiste à réaliser une analyse syntaxique en dépendances permettant d'extraire un ensemble de traits syntaxiques pour chaque mot analysé. La similarité distributionnelle entre un mot polysémique et un de ses voisins consiste à déterminer le nombre de traits syntaxiques partagés. La deuxième approche consiste à utiliser un modèle de représentation vectorielle continue des mots dans un espace à n dimensions. La similarité consiste ici à comparer le vecteur du mot polysémique et le vecteur de chacun de ses voisins. Par exemple, pour Paris, la distance distributionnelle permet de regrouper capitale et France.

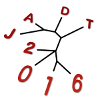

Nous pouvons voir notre méthode comme un processus à deux niveaux. Le premier sélectionne les voisins les plus proches au moyen d'une similarité distributionnelle, le deuxième permet de lever les ambiguïtés au moyen d'une similarité sémantique. La similarité distributionnelle entre le mot à désambiguïser et chacun des voisins sélectionnés est plus forte que celle du mot à désambiguïser et chacun des autres mots du contexte. La similarité sémantique que nous utilisons repose sur les définitions des sens. Le sens candidat choisi pour un mot polysémique est celui qui partage le plus de traits sémantiques avec les sens des voisins sélectionnés, à titre d'exemple le sens justice du mot avocat partage plus de traits sémantiques avec le sens législation du mot loi que le sens fruit peut partager. Le test et l'évaluation de notre méthode portent sur le corpus SemCor (Miller et al., 1993), le plus grand corpus en anglais annoté sémantiquement avec WordNet (Fellbaum, 1998). Il contient 352 textes avec près de 234,000 occurrences de mots annotées. Nous utilisons le réseau sémantique BabelNet comme base de connaissances. Les résultats de désambiguïsation obtenus en tenant compte des voisins distributionnels sont meilleurs que la simple utilisation des voisins les plus proches linéairement. D'autre part, le temps de traitement est largement réduit.