Ce travail compare différentes méthodes permettant d'étudier les relations entre des classifications lexicales, que nous restreindrons ici aux classifications utilisant la méthode Reinert (1990), issues de corpus différents. La méthode Reinert, qui se singularise notamment par l'utilisation du segment de texte comme unité, permet de repérer les différentes thématiques qui apparaissent dans les corpus textuels. Dans certains champs d'application des outils permettant ces analyses, les chercheurs sont amenés à travailler sur des corpus qui, bien qu'apparaissant dis-joint a priori, entretiennent des proximités matérialisées par la congruence de certaines des thématiques identifiées. Nous chercherons donc à rendre saillante les proximités et les distances entre les thématiques issues de ces classifications et à spécifier la nature de ces relations. Pour ce faire, nous comparerons les apports et les limites 3 méthodes :

-

une analyse factorielle des correspondances sur le tableau lexicale complet (Lebart & Salem, 1994) regroupant plusieurs classifications.

-

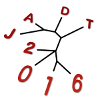

une mesure des distances textuelles avec l'indice de Labbé (Labbé & Labbé, 2001) sur les ensemble de segments regroupés dans les classes. Dans cette approche, les segments des classes de la CHD sont considérées comme des nouveaux corpus et les distances inter-classes sont calculées entre les classifications relevant de corpus différents. Une CHD (méthode Ward) sur la matrice des distances obtenues permet de visualiser les proximités et les distances entre ces classes.

-

une utilisation des Tgens (Lamalle & Salem, 2002) inspirée des travaux de Marty, Marchand & Ratinaud (2012). Il s'agira de construire le TGen des formes sur-représentées dans les classes d'une analyse et d'étudier la projection de ce Tgen sur une classification cible. Cette méthode permet entre autre de pouvoir spécifier le lexique responsable d'une sur-représentation du Tgen dans la classe.

Nous appliquerons ces méthodes à l'étude des relations entre les contenus des sites web de partis politiques (Front national, Parti socialiste, Europe Ecologie Les Verts) et une analyse sur l'ensemble des débats de l'assemblée nationale entre 1998 et 2014 (Ratinaud & Marchand, 2015). Les analyses seront réalisées à partir des logiciels IRaMuTeQ et R.

Labbé, C., & Labbé, D. (2001). Inter-Textual Distance and Authorship Attribution Corneille and Moliere. Journal of Quantitative Linguistics, 8, 3, 213-231.

Lamalle C., & Salem A. (2002). Types généralisés et topographie textuelle dans l'analyse quantitative des corpus textuels. Actes des 6e Journées d'analyse des données textuelles, St Malo, 2002.

Marty, E., Marchand, P., & Ratinaud, P. (2013). Les médias et l'opinion: éléments théoriques et méthodologiques pour une analyse du débat sur l'identité nationale. Bulletin de Méthodologie Sociologique, 117(1), 46–60.

Ratinaud, P., & Marchand, P. (2015). Des mondes lexicaux aux représentations sociales. Une première approche des thématiques dans les débats à l'Assemblée nationale (1998-2014). Mots. Les Langages Du Politique, 2015(108), 57–77.

Reinert, M. (1990). ALCESTE : Une méthodologie d'analyse des données textuelles et une application : Aurélia de Gérard de Nerval. Bulletin de méthodologie sociologique. 26. 24-54.